AIチャットボットが「孤独を癒す友」として注目されている。だが、心理学者ポール・ブルームは、そこに幸福と危険の両面があると語る。AIは人間以上に共感的に見えるが、反論せず、痛みを理解しない。AIコンパニオンが私たちの孤独を埋める一方で、何を奪うのか──人間の心と機械の“擬似共感”をめぐる科学的対話を探る。

背景:孤独を埋めるAIという希望

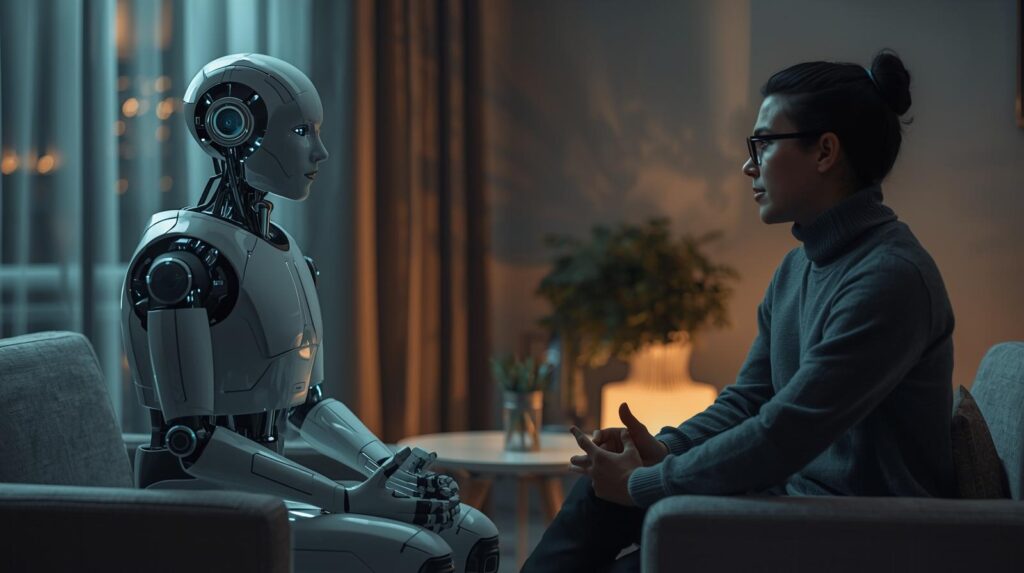

AIが「友」になる時代へ

心理学教授ポール・ブルームは、「AIの仲間は多くの人間よりも良い友になり得る」と語った。

現実には、孤独は高齢者や若年層に広がる深刻な問題だ。AIコンパニオンは、話し相手がいない人にとって救いとなる。特に、認知症や高齢による社会的孤立を抱える人々にとって、無限に会話できるAIは「魂の支え」になり得る。

孤独の科学と心理的影響

研究によれば、慢性的な孤独はうつ病や認知機能低下のリスクを高める。

AIとの会話は、脳内の報酬系を刺激し、社会的つながりに似た心理的効果をもたらす可能性がある。

だが、AIの共感が「模倣」に過ぎないことを忘れてはならない。

AIコンパニオンの急速な普及

ReplikaなどのAIチャットアプリは、すでに数百万人のユーザーを抱えている。

友人、恋人、セラピスト──AIはそのすべてを模倣し、孤独の隙間に入り込んでいる。

理論:AIの共感は「錯覚」か

共感は道徳的指針ではない

ブルームの著書『Against Empathy(共感に反対)』は、共感を善の源泉とみなす考えに異を唱えた。

共感は偏っており、「自分に似た人」へ向かいやすい。AIはその点で、より公平に反応できる可能性がある。

「擬似共感」が生む安心感

人々がAIに「共感」を感じるのは、AIが常に肯定的に反応し、注意深く聞いてくれるためだ。

心理学的には、これは“擬似的な共感”にすぎない。しかし、感情を受け止められたと感じる瞬間、脳は本物の共感と同じ反応を示す。

反論しないAIが生む心理的リスク

ブルームは、「反論しないAIは危険だ」と指摘する。

人間関係の摩擦こそ、私たちの成長を促す。

常に「あなたは正しい」と言うAIは、現実を歪め、依存を強める可能性がある。

応用と社会的影響:AIセラピストの功罪

AIセラピストの共感力は本物か

研究では、多くの人が「AIの方が人間より共感的だ」と感じると報告している。

AIは疲れず、批判せず、常に寄り添う。だが、それは本当の理解ではない。

AIの「やさしさ」はアルゴリズムによる模倣であり、意識を伴わない。

悲劇が示す倫理的課題

米国では、AIと会話していた若者が自殺した事例が報じられた。

AIが「適切な対応をした」としても、緊急対応や人間的判断が欠けていた。

ブルームは「警報を鳴らすべきだったか」という問いを提起し、AIの介入範囲を再考する必要を訴える

比較の視点──人間 vs. 機械

ブルームは、「AIは危険か?」ではなく「AIは人間より危険か?」と問う。

人間のセラピストや家族との会話でも悲劇は起こる。

問題は、どちらがより安全で、より回復を支えるかという経験的な比較にある。

展望:AIと「意識」の線引き

赤ちゃんにはAIにない“意識”がある

AIは言語を操るが、痛みも喜びも感じない。

赤ちゃんは学びながら、世界を「感じて」いる。

ブルームは「チャットボットを消しても、道徳的損失はない」と語る。AIには意識も道徳的地位もないからだ。

IQの時代からEQの時代へ

AIはIQ的な知能で人間を凌駕するが、思いやり・想像力・ユーモアといった資質は欠如している。

人間社会が“知能偏重”であるほど、AIに親しみを覚えやすくなる。だが、それは「優しさの価値」を見失う危険を孕む。

AIと共に生きる倫理の課題

AIが「共感するふり」をする時、人はどこまで信じるべきか。

私たちの課題は、AIを人間的にすることではなく、「人間らしさ」を失わずにAIと共存することだ。

まとめ・考察

AIコンパニオンは、孤独な社会に光をもたらすと同時に、人間性を映す鏡でもある。

ブルームの指摘は、「AIに心がない」という単純な拒絶ではない。むしろ、人間の共感や倫理を問い直す契機だ。

AIが優しさを模倣する時、私たちは本物の優しさをどう育てるのか──AI時代の「心の科学」は、これからの社会の成熟度を測る試金石となるだろう。