なぜAIへの信頼が重要なのか

AI信頼の社会的背景

近年、人工知能(AI)の進展は医療、教育、金融、交通などあらゆる分野で急速に進んでいます。AIは人間の限界を超える処理能力を提供しますが、その「判断」がどれほど正確であっても、最終的には人間(医師、患者、利用者)がその判断を信頼しなければ有効性は発揮されません。信頼が欠如すると、診断結果の活用が遅れたり、誤判断に繋がる危険性もあります。AIシステムの社会実装のボトルネックは、技術的な性能ではなく、人間心理にあると言えます。

信頼欠如の具体例:透明性の問題

過去には、Googleの写真分類AIが人種差別的な分類結果を出した事例や、Microsoftのチャットボットが不適切な発言を行ったケースも報告されており、これらはAIへの信頼を損なう大きな要因となりました。特に、オランダで発生した福祉給付の不正検知AIシステム(SyRI)の誤判定事例では、数万人の市民が不当に不正受給者と認定され、「アルゴリズムの決定は覆せない」というAI統治の危険性が社会的に露呈しました(オランダAI「不正検知」システムによる差別の仕組みと教訓 – WIRED.jp)。また、Intelの調査では、患者の36%が医療AIに対する信頼を欠いていることが分かっており、信頼の欠如はAI導入の障壁となることが明らかになっています。これは、AIの判断過程がブラックボックス化していることに起因しています。

信頼を科学的に評価する意義

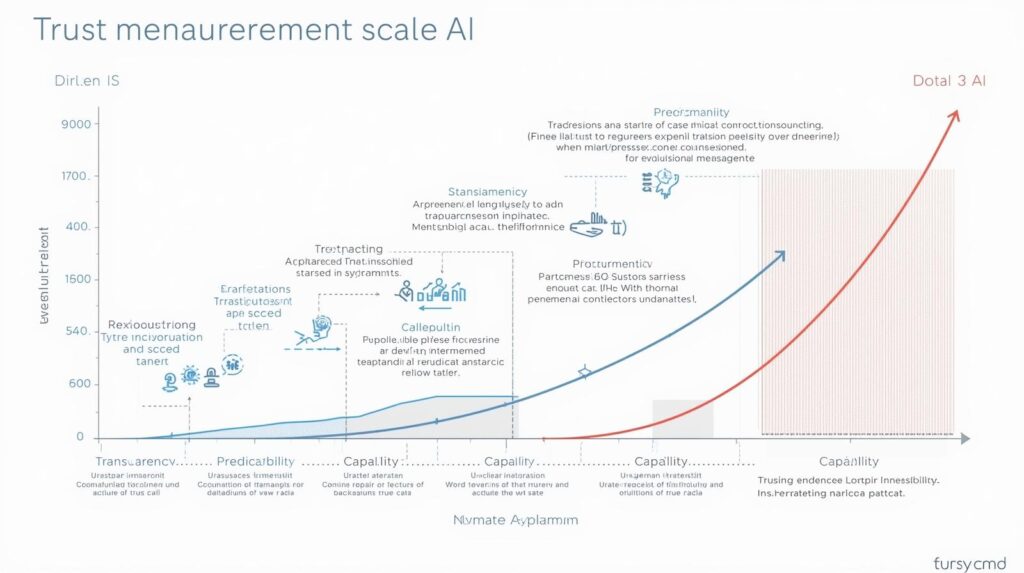

AIの受容や効果的な活用を促進するためには、単に「信じる・信じない」といった主観的な感情論ではなく、心理学的に定量化された尺度で信頼度を測定し、科学的にシステムを改善することが重要です。**Larastiらの研究**では、こうした人間とAIの信頼を科学的に評価する新しい心理尺度が開発されました。この尺度は、AIが人間の生活に深く関わる時代において、倫理的・社会的な受容可能性を担保するための科学的基盤となります。

メカニズム・理論:信頼態度測定尺度の構造

信頼態度の多次元的構造の解明

Larasti氏らは、AIシステムに対する人間の信頼を定量化するため、16項目からなる多次元的な心理尺度を開発しました。従来の信頼評価が単純なアンケート形式に依存していたのに対し、本尺度は信頼を以下の複数の要素に分解して評価します。

- 能力(Competence): AIがタスクを正確かつ効果的に実行できるか。

- 透明性(Transparency): AIの判断根拠やプロセスが理解可能か。

- 予測可能性(Predictability/Consistency): 同様の入力に対して常に一貫した結果を出すか。

- 誠実性(Integrity): 倫理規範やユーザーの利益に反しないか。

- 操作の容易さ(Ease of Use): システムの利用が直感的で負担が少ないか。

開発プロセスは、項目作成→評価→調査実施→次元性検証→信頼性テスト→妥当性テストの6段階から成り、心理学、人間工学、ヒューマン・コンピュータ・インタラクション(HCI)の知見を統合することで、統計的に**高い信頼性(Reliability)と妥当性(Validity)**を担保しています。

認知心理学との接続:感情と認知のバランス

信頼は単なる感情ではなく、システムの性能に対する**「認知的評価」と、システムへの安心感や親近感といった「感情的評価」の組み合わせです。AI信頼尺度は、こうした複雑な心理構造を可視化し、AIと人間のインタラクションをより科学的に理解する手段を提供します。例えば、AIの判断の「透明性」を高めることは認知的な信頼を高め、「操作の容易さ」**を高めることは感情的な抵抗を減らすことに繋がります。

応用・社会的影響・実例:科学的信頼評価の拡張

医療分野での「過剰信頼(Over-Reliance)」リスクへの応用

医療AI支援システムでは、患者や医師の信頼度がAI活用の可否に直結します。本尺度は、システム導入前にユーザーの信頼を測定し、信頼性向上のための改善ポイントを明確化できるだけでなく、**「過剰信頼(Over-Reliance)」のリスク評価にも役立ちます。AIの判断を人間が盲目的に受け入れ、人間のチェック機能が麻痺してしまう現象は医療ミスに直結する危険性があるため、この尺度は「最適な信頼度」**を測る指標として活用されます。

教育・金融・公共サービスへの拡張(実例の深掘り)

- 公共サービス: 台湾の「vTaiwan」プロジェクトのように、AIが市民の声を整理し、議論の透明性を高めることで、政府への信頼を高め、**参加型民主主義(Participatory Democracy)を技術的に支援**します。

- 教育分野: AI学習支援システムが、生徒や教師に「なぜこの問題を推奨するのか」を説明する透明性を高めることで、システムへの信頼が向上し、学習効果の継続的な向上に繋がります。

- 金融分野: 自動取引システム(アルゴリズム取引)に対する投資家の予測可能性と誠実性の評価は、市場リスク管理と金融の透明性向上に不可欠です。

この信頼尺度の導入により、AI設計者はユーザーの心理を反映したAI開発が可能になり、AI技術の社会浸透が加速します。AIを単なるツールではなく、人間と協働するパートナーとして位置づけることが可能になるのです。

今後の展望や議論:倫理と信頼性の統合

倫理的配慮と説明責任(Accountability)の確立

AIの透明性、説明責任(Accountability)、プライバシー保護など倫理的課題は、信頼の基盤です。説明可能なAI(XAI)の必要性に関する総務省レポートでも示されている通り、AIの判断が人権や生存権に影響を及ぼす場合、誰が最終的な責任を負うのかという「説明責任」の制度設計こそが、ユーザーの根本的な安心感(信頼)を支えます。また、AIを過信する「過剰信頼」だけでなく、不当に不信感を抱く「過小信頼(Under-Reliance)」のリスクにも注意が必要であり、信頼尺度を用いたバランス評価が求められます。

AIと人間の共生の未来は、技術開発だけでなく、ユーザー心理と倫理を重視したAI設計指針の確立にかかっています。